一 : 搜索引擎网页排名作弊的方法以及惩罚

排名作弊的两个常用方法:采集+群发

一般来说,一个网站获得排名成功的主要标准是内容与链接,令人遗憾地是一些搜索引擎优化人员却将其对应于采集与群发。通过采集器进行内容简单收集堆积及群发器肆意增加外部链接就可以玩弄搜索引擎吗?其实这是玩火自焚!之前我用www.60hao.cn这个域名做过一个实验站,通过大量的群发链接确实将“免费”这个关键词做到了google第3的位置,不过仅仅持置续了2天的时间。现在这个域名已经被K了。在此告诫大家好内容是关键,留住访客才是我们最终的目的!

据悉,网站采集的方式主要包括两种,一种是CMS系统自带的采集功能,如asp的风讯CMS、php的织梦CMS;另外一种是专门采集工具,如火车头采集器,他们的原理都是按照目标网站页面的HTML规则进行摘取内容按规则存入本地数据库中,然后输出。另外比较极端的是整站下载器,将网站所有静态文件下载到本地,然后整站修改url等上传,更厉害的就是小偷程序建站,实时盗取别人的网站内容,其实这不算采集,只是读取了目标页面的数据在域名下展示,类似于镜像站。采集造成影子站、垃圾站,这正是百度近期大量K站的原因!

现在被黑帽SEO用烂的群发软件一般包括:客评论及引用trackback群发,论坛信息群发,网站留言群发等。

为什么很多人都乐此不疲地热衷于采集及群发呢?大概与百度和Google两大搜索引擎的排名规则有很大关系。因为Google的排名算法中对外部链接广度所占的比重较大,基于知识产权的保护而对复制内容进行降权处理,但似乎通过链接也可以将补充材料逆转成正常结果,所以外链群发对Google也有些效果。百度喜欢更新频繁的网站,很多SEO都有这种共识,外部链接广度的作用并不那么突出,而百度加入了人工干预,对页面的展示效果要求也高。短期内增加大量外链,正是搜索引擎惩罚的对象!

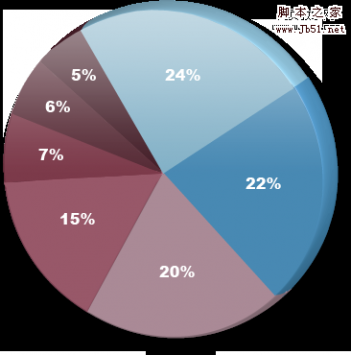

二 : 2009年影响网站搜索引擎排名的重要因素小结

- 24% 域名的权威性和信誉

- 22% 页面的外链数量和质量

- 20% 外部链接的锚文字

- 15% 页面上关键字使用情况

- 7% 流量和点击率

- 6% 网络社交关系指标

- 5% 域名注册和主机数据

5个对搜索引擎排名最重要的因素

-

73%非常重要

外部链接含有关键字的锚文字 -

71%非常重要

外部链接广度(外部链接的数量和质量) -

67%非常重要

外部链接源的多样性(有很多来自不同域名的链接) -

66%非常重要

在Title标签中使用关键字 -

66%非常重要

基于从可信任域名到网站链接距离的可信赖度(比如: trustrank,domain moztrust,等等)

5个对搜索引擎排名最负面的因素

-

68%非常重要

有意或恶意隐藏作弊 -

56%很重要

从已知的链接商购买链接 -

51%一般重要

链接到垃圾(Spam)网站或页面 -

51%一般重要

隐藏用户代理 -

51%一般重要

经常down机、网站不能访问

5个最具争议的因素

- 利用Cookie探测器作弊 16.3% 强烈争议

- 利用Javascript/富媒体支持探测器作弊 15.4% 中度争议

- 使用背景颜色来隐藏正文的文字 15.3% 中度争议

- 通过IP地址隐藏作弊(Cloaking by IP Address) 1153% 中度争议

- 通过侦测客户端(User-Agent)作弊 15.2% 中度争议

关于此问卷调查

每两年,SEOmoz都向世界各地的SEO专家们做有关搜索引擎排名算法的调查。今年主要收到了美国、英国、加拿大、澳大利亚、新西兰、冰岛、乌克兰和多米尼加等地方的回复。

每个参加调查的人通过回答特定的问题来评估超过100个有关搜索引擎排名的因素。这篇文章代表了这些专家集体的智慧,也给了SEO各个提供了很好的资源。

三 : 浅谈如何快速提高二级域名新站获得搜索引擎的排名

搜索引擎的不信任是每一个新上线的站点最头痛的,那么对于二级域名来说怎么样更加快速的获得搜索引擎的青睐呢?笔者将在下文中分享自己的三点心得一、单向链接过多不一定就有好处

作為优化人员应该都清楚单向链接和双向链接的定义,向我们的友情链接就是一种双向链接,两个站点之间权重的传递时互相的。而假如我们购买一些链接,如黑链的话就是一种单向的链接,而单向链接的权重传递自然而然是单向的。没错,这一类的单向链接有益与站点权重的累积,而有的站长就认為这一类链接越多越好,但是笔者认為不然,尤其是对于我们一个刚刚上线的新站来说是不好的。试想一下,一个刚成立的二级域名新站怎么样会有这么多的单向链接,搜索引擎会认為你的站点是使用作弊的手段。而这种不正常的现象不仅不能让你提早走出搜索引擎的审核期,相反的会延长你的审核期。而刚开始的这一不好的印象,也将会影响到你接下去站点的收录于排名。

二、提高主站权重

有做过二级域名优化的人都可能会遇到过这种情况,只要二级域名被降权的话,我们的顶级域名也会被影响到,对于搜索引擎来说你的二级域名是一个独立的站点,同時它也和我们的主域名网站有着很微妙的关系。我们可以打个比方,假如我们有一个主站,而假如我们在短期内在这个主域名下开通了好几个二级域名,那么对于我们的总站也会产生很大的影响。二级域名对于主域名有一定的权重依赖,假如主域名收录好,排名好,权重高,那么也会对我们的二级域名有促进的用途的。因此笔者建议假如你想要开通多个二级域名的话,最好不要一下子都开好,循序渐进,此外对于主域名权重的提高也是不能忽视的

三、网站内链的构建

构建一个合理的站内结构,原因不仅仅是为了提供一个利于我们优化的环境,更重要的是为了提高用户的友好体验度,假如我们把一个站点形容是一个生物,那么内链就是连接各个部位的的血管、神经等等。对于一个二级域名新站来说,我们应该更加的注重哪几方面的问题呢?

1:robot.txt文件

网站的robot.txt文件是用来阻止搜索引擎收录的,基本上每个网站的根目录都会设置的。假如我们网站哪些页面是想给用户看不想给搜索引擎看,那么我们的robot.txt文件就可以阻止搜索引擎收录。

2:站点的404页面

对于404页面设计的好处有两点,一是可以很好的降低站点的跳出率,而是对于搜索引擎来说,就像是给搜索引擎说明该页面已經不存在了,使其不会把这个页面当成是一个死链接。

3:网站url设计

对于二级域名的新站来说,URL地址要尽量的短而且易记,最好使用静态的URL地址,而且目录不要太复杂,否则的话可能会影响到站点的收录情况。

对于二级域名新站的优化,笔者就简单的分享这几点自己的心得。二级域名的优化相比于顶级域名的话优化难度会更加的大,要获得搜索引擎的信任会更加的难。但是笔者认為找到一个正确的方向,之后坚持不懈的朝这个方向前进,就可以获得不错的成绩。